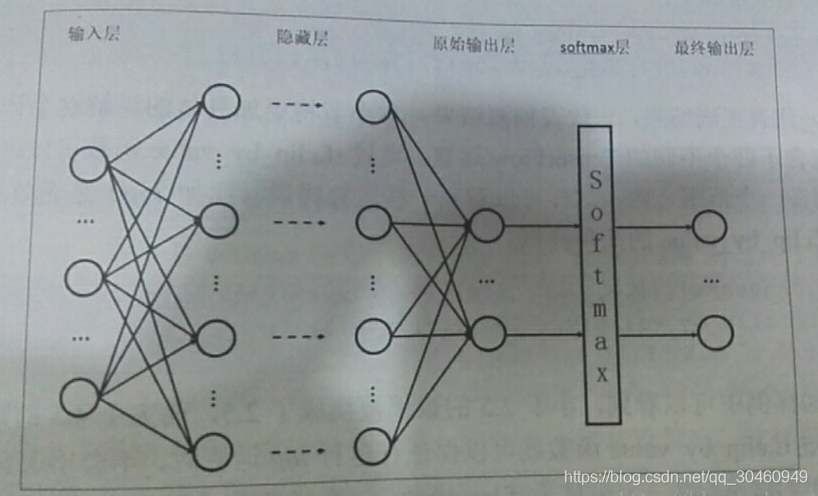

全连接层与Softmax原理详解及应用场景分析

在深度学习网络中,全连接层(Fully Connected Layer)是一种基础的神经网络结构,其核心功能是将前一层的所有神经元与当前层的每个神经元建立全局连接。假设前一层的输出是维度为$n$的向量$X=[x_1, x_2, ..., x_n]$,全连接层通过权重矩阵$W$(维度为$m \

imes n$)和偏置向量$B=[b_1, b_2, ..., b_m]$,计算得到输出$Y = W \\cdot X + B$。这里的$m$代表当前层的神经元数量,每个神经元对应一个特征维度。全连接层通常搭配激活函数(如ReLU)使用,以增强非线性表达能力。

Softmax函数则是多分类任务中的核心组件,其数学表达式为:

$$

ext{Softmax}(y_i) = \\frac{e{y_i}}{\\sum_{j=1}k e{y_j}}

$$

它将全连接层的输出$y_1, y_2, ..., y_k$映射为概率分布,满足$\\sum_{i=1}k \

ext{Softmax}(y_i) = 1$。通过指数运算,Softmax会放大较大值的比重,同时抑制较小值的贡献。例如,若全连接层输出为$[3, 1, 0.5]$,经过Softmax处理后可能得到$[0.84, 0.11, 0.05]$,直观体现类别概率。

核心原理剖析

1. 全连接层的计算特性

参数密集性:全连接层的参数量为$m \

imes n + m$,当输入维度$n$较高时(如图像分类中$n=4096$),参数规模可能达到百万级,这既是其特征融合能力的来源,也是过拟合风险的成因。

全局特征整合:与卷积层关注局部特征不同,全连接层通过密集连接整合全局信息,适合处理需要综合判断的任务,如分类、回归。

2. Softmax的动态特性

温度参数(Temperature):在Softmax公式中引入温度系数$T$(即$e{y_i/T}$),可调节概率分布的尖锐程度。$T>1$时分布更平滑,适合模型蒸馏;$T<1$时分布更集中,增强分类置信度。

数值稳定性:实际实现时会对输入做$y_i

\\max(y)$处理,避免指数运算溢出。

应用场景与工程实践

1. 图像分类任务

经典网络(如VGG、ResNet)通常在卷积层后接2-3个全连接层,最后一层通过Softmax输出类别概率。例如ResNet-50中,全连接层将2048维特征映射到1000维(ImageNet类别数)。

优化技巧:使用Dropout(如VGG中Dropout率为0.5)或权重正则化(L2正则)缓解过拟合;批量归一化(BatchNorm)加速训练收敛。

2. 自然语言处理

在文本分类模型中,全连接层可将词向量或LSTM输出的特征转换为类别空间。例如BERT模型在预训练后,通过添加全连接层+Softmax适配下游任务(如情感分析)。

低秩适配:当类别数极大(如推荐系统中的百万级物品分类)时,可对全连接层权重矩阵进行低秩分解(如使用双线性层),将参数量从$O(mn)$降至$O(m+n)$。

3. 多模态模型

在视觉-语言模型(如CLIP)中,全连接层用于对齐图像和文本的嵌入空间,Softmax计算跨模态相似度得分。此时温度参数需通过对比学习优化。

局限性及替代方案

计算效率瓶颈:全连接层的计算复杂度为$O(mn)$,当输入为高分辨率特征图时(如7x7x512),可先用全局平均池化压缩维度。

过度参数化问题:轻量化网络(如MobileNet)常将全连接层替换为1x1卷积,保留空间信息的同时减少参数。

Softmax的替代者:在度量学习(Metric Learning)中,ArcFace等损失函数通过改造Softmax的几何解释,提升特征判别性。

总结

全连接层与Softmax的组合是深度学习中端到端分类建模的基石。其设计需权衡特征表达力与计算成本,在图像、文本、多模态等领域均有不可替代的价值。理解其数学本质及工程实现细节,是优化模型性能的关键。

发表评论